유명 AI유튜버들의 콘텐츠들에게 “hallucination은 궁극적으로 해결될 수 있는가?”라는 질문을 던져본 결과입니다.

‘Hallucination’은 AI 모델이 통계적 패턴 학습에 의존하여 완전히 창조된 또는 부정확한 정보를 생성하는 현상을 가리킵니다. 이 문제는 AI 분야에서 일반적인 도전 과제로 인식되며, 이를 해결하기 위한 다양한 접근 방법이 제시되었습니다.

첫 번째로 모델 자체의 창조성을 활용하는 방식이 있습니다. hallucination은 때때로 긍정적인 요소로 작용할 수 있습니다. 창조적 브레인스토밍이나 창작활동 등에서 이러한 ‘hallucination’은 유용하게 활용될 수 있습니다(2023-06-02).

두 번째로, 모델의 응답을 개선하는데 커뮤니티 제안을 활용하는 것입니다. ChatGPT와 같은 모델들은 때때로 hallucination을 통해 공기 중에서 답변을 창출해내기도 하는데, 이러한 문제를 개선하기 위해 커뮤니티의 제안을 활용하는 방식이 유용하게 사용될 수 있습니다(2023-10-05).

세 번째로, 모델의 응답을 ‘팩트’ 단위로 나누고 그것들을 문서 컨텐츠와 대조하는 방식이 있습니다. 이 방법이 통해 hallucination을 식별하고 결과로서 나온 정확성 지표를 기반으로 hallucination을 차단할 수 있습니다(2023-11-13).

하지만, 모든 hallucination이 반드시 부정적인 것은 아니며 때때로 창조성과 통찰력을 제공하기도 합니다. 대부분 엔지니어들이 hallucination을 부정적인 현상으로 보지만, 이를 ‘창조성’의 결과라고 봄으로써 긍정적으로 활용할 수도 있습니다(2023-06-22).

일부 목적에 대해서는, 특히 약물 탐색과 같은 분야에서는 hallucination 기능이 실질적인 가치를 제공할 수 있습니다. 대형 언어 모델에 대해서는 hallucination이 정보를 단지 창조하는 문제를 초래하지만, 특정 분야에서는 이것이 유용한 특성으로 작용할 수 있습니다(2023-12-09).

따라서, hallucination 문제는 제한적인 컨텍스트에서 창조적인 특성으로 활용될 수 있음을 볼 때, 궁극적으로 완벽하게 해결되는 것이 반드시 최선의 방법이라고는 볼 수 없습니다. 그러나 여러 방법들이 제안되고 개발되어, AI 모델에 의한 hallucination현상에 대해 상당한 개선이 이루어질 수 있다는 점은 분명합니다.

참고자료

2023-06-02: YouTube)

++++++++++++++++++++++++

다음은, AI연구분야의 최근 논문들에게 “hallucination은 궁극적으로 해결될 수 있는가?”라는 질문을 던져본 결과입니다.

‘Hallucination’은 대규모 언어 모델(Large Language Models, LLMs)에서의 주요한 문제점 중 하나로, 현재까지 많은 연구가 이를 줄이는 방향으로 이루어지고 있습니다. 이를 해결하기 위한 다양한 해결책이 제안되고 있으며, 그 중 하나는 ‘Ever’라는 시스템이며, 텍스트를 생성하는 과정에서 실시간으로 hallucination을 탐지하고 교정하는 전략을 사용합니다. 또 다른 연구에서는 hallucination을 약 44.6%까지 감소시키는 성공적인 방법을 보여주고 있습니다. 그러나, 지금까지의 연구 결과들은 주로 경험적인 치료법에 의존하고 있으며, hallucination을 완전히 없앨 수 있을지에 대한 근본적인 질문에는 답하지 못하고 있습니다. 한 연구에서는 hallucination이 LLMs에서 완전히 제거되는 것은 불가능하다는 결론을 내렸습니다. 다시 말해, hallucination문제의 궁극적인 해결은 아직 어렵다는 것을 알 수 있습니다.

++++++++++++++++++++++++++++

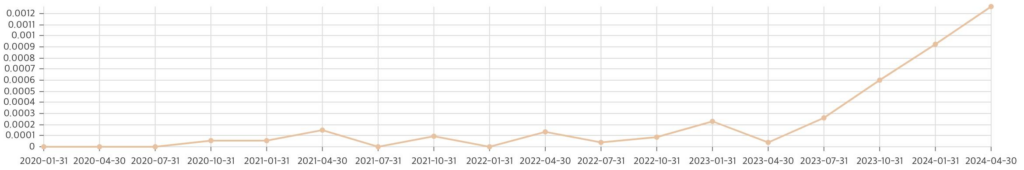

이 질문의 중요도는 다음과 같이 변화하고 있습니다.

이 질문과 관련된 첫번째 자료는 2020년에 이미 출판되었습니다.

- Controlled Hallucinations: Learning to Generate Faithfully from Noisy Data (https://arxiv.org/abs/2010.05873)