*** 이번 포스트는 ACM Interactions 지에 실린 “Human-AI Interaction: Intermittent, Continuous, or Proactive”라는 제목의 논문(아래의 외부링크 참조)을 적절히 풀어서 설명합니다. ***

Human-AI Interaction

AI 기술이 발전하고 관련 서비스가 늘어남에 따라 사람과 AI 시스템 사이의 인터랙션(Human-AI interaction)에 대한 고찰의 필요성이 점점 높아지고 있습니다. AI 시스템에 명령을 내리면 원하는 답을 제공해 주는 것이 가장 간단한 예가 되겠지요.

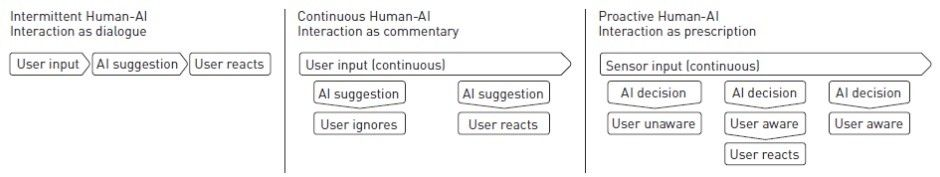

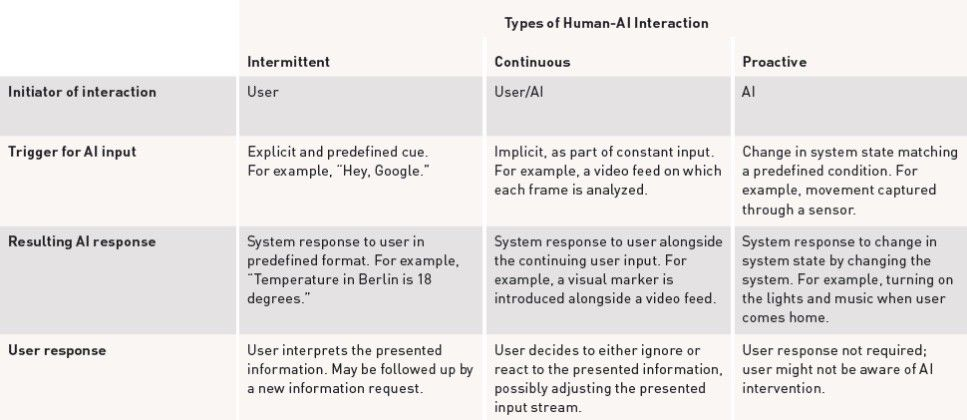

이와 같은 Human-AI interaction은 세가지 타입의 패러다임으로 구분할 수 있습니다.

(1) Intermittent

Intermittent 타입은 가장 기본적인 인터랙션입니다. 사람이 인터랙션을 시작하고 AI 시스템이 이것에 반응하는 것이죠. 주로 사람이 명령을 내리면서 인터랙션이 시작되며, 명령을 내릴 때 명확한 정보와 제약조건을 AI 시스템에 제공해야 원하는 반응을 얻을 수 있습니다.

예를 들어, AI 시스템에게 날씨를 묻고자 한다면 시간과 위치 정보를 알려줘야겠지요. “오늘 우리집 근처의 날씨는?” 또는 “내일 대전 유성구의 날씨는?” 등과 같이 말이죠.

사람은 AI 시스템의 반응이 자신이 원하는 것인지 평가하게 되고 원하는 것이 아닐 경우에는 다시 명령을 내리게 됩니다. 따라서 이 타입을 “turn-taking process”, 또는 “interaction as dialogue”라고 부릅니다.

현재의 human-AI interaction의 많은 부분이 이런 개념에 초점을 맞추고 있지만 human-AI interaction이 꼭 이렇게 딱딱한 패턴을 따라야 하는 것은 아닙니다.

(2) Continuous

사실, 실제 환경에서는 사람이 특정 순간에만 AI 시스템과 인터랙션하기 보다는 지속적으로 인터랙션하는 경우가 많겠지요. 일상적인 사람의 행동은 기본적으로 continuous 하니까요. 예를 들어, AI를 탑재한 운전 교육 시뮬레이터를 쓴다고 하면 사람과 AI 시뮬레이터는 운전 교육을 진행하는 동안 지속적으로 인터랙션하게 됩니다. AI 시뮬레이터를 쓰는 도중에 잘못된 조작을 하거나 에러가 발생하면 AI 시뮬레이터가 그에 적합한 피드백을 해 주기를 기대하면서요. AI 시뮬레이터는 사람에게 적절한 피드백을 제공해야 하죠.

AI 시뮬레이터를 쓰면서 사람이 일일이 AI 시뮬레이터에 피드백을 요청해야 한다면 사용할 수 없을 겁니다. 지속적으로 입력되는 정보를 AI 시뮬레이터가 계속 분석하고 있다가 필요한 경우에 반응해야 하는 것입니다. 워드프로세서를 사용하여 문장을 작성하는 동안 문법 교정이 필요하거나 오타가 난 부분을 알려주는 서비스가 이것에 해당합니다.

이러한 타입의 인터랙션을 하는 AI 시스템을 구현하려면, 사람이 자신의 일을 진행하는 것을 방해하지 않으면서 적절한 피드백을 제공하는 방법을 고민하는 것이 중요합니다. 또한 주로 AI 시스템이 제공하는 피드백에 사람이 반응하는 형식의 인터랙션이 되므로, AI 시스템을 대상으로 취할 액션을 계획하고 수행하는 과정에 필요한 사람의 인지적 부담을 덜 수 있습니다. 물론 잘못 설계될 경우 역효과가 날 수 있습니다.

이 타입은 “interaction as commentary”라고 부르기도 합니다.

(3) Proactive

이 타입의 인터랙션에서는 AI 시스템이 사람의 입력을 기다리지 않고 스스로 상황을 판단하고 직접 적절한 동작을 선택하여 수행합니다. 심지어 AI 시스템이 동작하고 있다는 것을 사람이 인식하지 못하기도 하죠.

가장 대표적인 것은 센서값을 바탕으로 직접 판단하고 액션을 취하는 홈 오토메이션 시스템입니다. 사람이 집에 들어오면 스스로 불을 켰다가 시간이 지나면 불의 밝기를 낮추는 것과 같은 AI 시스템이 해당됩니다. 물론 AI 시스템이 취한 동작의 결과가 적절하지 않을 경우 사람이 직접 AI 시스템의 판단 기준을 조절할 수는 있습니다.

이 타입은 상황 판단을 내리고 동작을 취하는 주체가 사람이 아니라 AI 시스템이므로 “Interaction as Prescription” 이라고 부릅니다.

Looking Ahead

HCI 커뮤니티는 continuous 타입과 proactive 타입의 human-AI interaction에 대해 아직 충분히 고려하고 있지 않습니다. 그러나 앞으로 사람들은 continuous 타입과 proactive 타입의 human-AI interaction에 대한 경험을 점점 더 많이 하게 될 것이므로, HCI 연구자들은 사람들이 새로운 경험에 걸맞은 mental model을 가질 수 있게끔 도울 필요가 있습니다. 사용자들의 mental model은 전통적인 turn-taking process에 맞춰져 있지만 이러한 모델은 continuous 타입과 proactive 타입의 human-AI interaction에는 적합하지 않기 때문입니다.

더 나아가, 미래의 AI 시스템을 개발하는데 있어서 fairness, accountability, 그리고 transparency의 개념이 중요해지고 있고 이러한 개념을 continuous 타입과 proactive 타입의 human-AI interaction에 어떻게 반영할 것인가를 연구해야 할 필요성이 높아지고 있습니다. 예를 들어, 지속적으로 시스템과 인터랙션하는 과정에서 시스템의 의사결정에 대한 투명한 설명을 사람에게 제공하는 것은 사람이 자신의 목적을 달성하는 것에 오히려 방해가 될 수 있으며, 한편으로는 예측하기 힘든 패턴으로 동작하는 AI 시스템에 대한 신뢰도는 금방 하락할 수도 있기 때문입니다. 이러한 상황에서 사람과 AI 시스템 사이의 인터랙션을 디자인하는 것은 많은 고민을 필요로 하지요.

이 포스트에서 언급한 세가지 패러다임은 병렬적으로 존재하며 이것들 중 하나가 완전히 사라지지는 않을 것입니다. 오히려 새로운 타입의 human-AI-interaction이 나타날 수 있죠. 따라서, 사용성 있는 AI-driven system을 만들기 위한 연구자들의 노력을 지원할 필요가 있습니다.