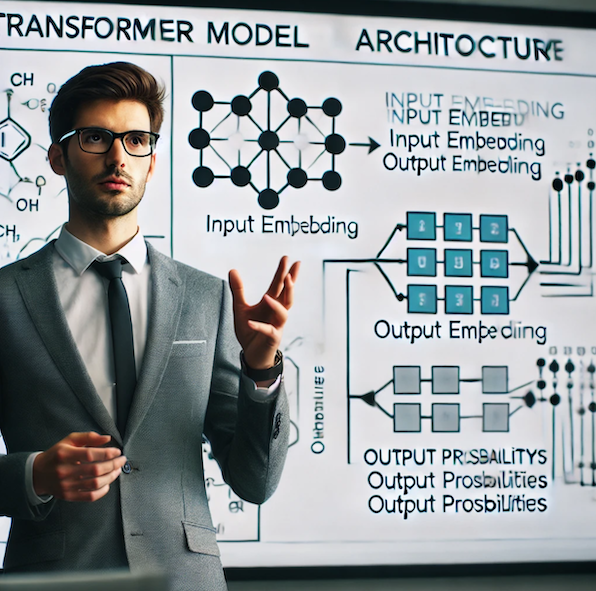

“Attention is All You Need” 논문은 2017년 Google Brain 팀에서 발표한 획기적인 연구로, 자연어 처리 분야에 혁명을 일으킨 Transformer 모델을 소개한 논문입니다. 이 논문은 BERT, GPT 등 현대 자연어 처리 모델의 기반이 되는 아키텍처를 제시했다는 점에서 매우 중요한 의미를 갖습니다.

이 글에서는 논문이 발표된 후 이 논문의 1저자인 Ashish Vaswani가 어떤 연구를 하였는지 설명합니다.

개요

Ashish Vaswani는 1986년생으로, BIT Mesra에서 컴퓨터공학을 전공했습니다. 2004년 미국으로 건너가 University of Southern California에서 박사 학위를 취득했으며, David Chiang 교수의 지도를 받았습니다. 그는 Google Brain 팀에서 연구원으로 근무했으며, 이후 Adept AI Labs의 공동 창업자로 활동했습니다. 현재는 Essential AI의 공동 창업자이자 CEO로 재직 중입니다.

Vaswani는 주로 Transformer 모델과 self-attention 메커니즘을 중심으로 한 연구를 통해 자연어 처리(NLP)와 컴퓨터 비전 분야에 큰 기여를 했습니다. 2017년부터 2018년까지는 Transformer 모델의 도입과 그 응용에 대한 연구가 주를 이루었으며, 특히 기계 번역과 같은 NLP 분야에서 뛰어난 성과를 보였습니다. 2019년부터 2020년까지는 self-attention을 활용하여 기존의 convolutional networks를 개선하거나 대체하는 연구를 수행하였습니다. 2021년부터 2022년까지는 Transformer와 self-attention 모델의 효율성 및 성능 개선에 중점을 두었으며, 다양한 새로운 아키텍처와 모델 효율성에 관한 연구에 참여하였습니다. 2023년부터 2024년까지는 Transformer 모델의 응용이 더욱 확장되어, 이미지 생성 및 시퀀스 생성과 같은 다양한 분야에 적용되었습니다.

시간에 따른 흐름의 변화는 Transformer 모델의 도입과 그 성능 개선, 그리고 다양한 분야로의 응용 확장으로 요약할 수 있습니다. 초기에는 NLP 분야에서의 성과가 두드러졌다면, 이후에는 컴퓨터 비전과 멀티모달 학습 등 다양한 분야로 확장되었습니다.

2017 ~ 2018

Ashish Vaswani는 주로 Transformer 모델과 관련된 연구로 잘 알려져 있습니다. Transformer는 주로 자연어 처리(NLP) 분야에서 사용되며, 특히 기계 번역에서 뛰어난 성능을 보여주었습니다. Vaswani의 연구는 주로 Attention 메커니즘을 중심으로 이루어졌으며, 기존의 Recurrent Neural Networks(RNN)나 Convolutional Neural Networks(CNN)와는 다른 접근 방식을 제시합니다.

Transformer 모델의 소개 : Vaswani는 Transformer라는 새로운 네트워크 아키텍처를 제안하였습니다. 이 모델은 Attention 메커니즘에만 기반하여, RNN이나 CNN을 완전히 배제하였습니다. 이로 인해 모델은 더 병렬화가 가능하고, 훈련 시간이 크게 단축되었습니다. 이 모델은 영어-독일어 번역에서 BLEU 점수 27.5를 기록하며, 기존의 최고 성능을 1 BLEU 이상 개선하였습니다. [1]

Combinatorial Generalization : Vaswani는 AI가 인간과 같은 능력을 얻기 위해서는 Combinatorial Generalization이 중요하다고 주장하였습니다. 이를 위해서는 구조화된 표현과 계산이 필요하며, Graph Network를 통해 이를 구현할 수 있다고 설명하였습니다. [2]

Transformer의 위치 정보 처리 : Transformer는 위치 정보를 명시적으로 모델링하지 않기 때문에, 입력에 절대 위치 표현을 추가해야 합니다. Vaswani는 Self-Attention 메커니즘을 확장하여 상대적 위치 표현을 효율적으로 고려하는 방법을 제안하였습니다. 이는 번역 품질을 개선하는 데 기여하였습니다. [3]

이미지 생성에서의 Transformer 적용 : Vaswani는 Transformer를 이미지 생성 문제에 적용하였습니다. Self-Attention 메커니즘을 지역적 이웃에만 집중하도록 제한하여, 더 큰 이미지를 처리할 수 있게 하였습니다. 이 모델은 ImageNet에서 기존의 최고 성능을 능가하였습니다. [4]

음악 생성에서의 Transformer : Vaswani는 음악 생성에 Transformer를 적용하여, 긴 구조를 유지하면서도 효과적인 결과를 얻었습니다. 상대적 위치 표현을 사용하여 메모리 요구 사항을 줄이고, 긴 시퀀스를 처리할 수 있게 하였습니다. [5]

Mesh-TensorFlow 소개 : Vaswani는 Mesh-TensorFlow라는 언어를 소개하여, 데이터 병렬성과 모델 병렬성을 결합한 효율적인 분산 텐서 계산을 가능하게 하였습니다. 이를 통해 최대 5억 개의 파라미터를 가진 Transformer 모델을 훈련할 수 있었습니다. [6]

2019 ~ 2020

Convolutional networks, self-attention, ImageNet, COCO : [7]에서는 convolutional networks에 self-attention을 결합하여 이미지 분류와 객체 탐지 성능을 향상시키는 방법을 제안하였습니다. 이 연구는 self-attention이 공간적 위치와 특징에 동시에 주의를 기울일 수 있도록 하여, 기존의 Squeeze-and-Excitation 메커니즘보다 더 나은 성능을 보여줍니다. 특히, ResNet50을 기반으로 한 ImageNet 분류에서 1.3%의 top-1 정확도 향상을 달성하였고, COCO 객체 탐지에서는 RetinaNet 기반에서 1.4 AP의 향상을 이루었습니다.

Convolutions, self-attention, ResNet-50, ImageNet : [8]에서는 self-attention을 convolutional networks의 보조 수단이 아닌 독립적인 구성 요소로 사용하는 가능성을 탐구하였습니다. ResNet-50의 모든 공간적 convolution을 self-attention으로 대체하여, FLOPS와 파라미터 수를 각각 12%와 29% 줄이면서도 ImageNet 분류 성능을 개선하였습니다. COCO 객체 탐지에서도 유사한 성능을 유지하면서 FLOPS와 파라미터 수를 각각 39%와 34% 줄였습니다.

Vision-and-Language Navigation(VLN) : [9]에서는 언어 이해가 목표 달성에 미치는 영향을 평가하기 위해 새로운 평가 지표인 Coverage weighted by Length Score (CLS)를 제안하였습니다. 또한, 기존 데이터셋의 경로가 지시사항을 따르기에 적합하지 않다는 점을 지적하며, 더 도전적인 경로를 포함한 새로운 데이터셋 Room-for-Room (R4R)을 소개하였습니다.

Self-attention, machine learning, unified representation space : [10]에서는 self-attention을 활용한 다양한 기계 학습 모델의 구현 방법을 설명하였습니다. 이 특허는 여러 입력 모달리티를 처리할 수 있는 통합 표현 공간을 활용하여, 다양한 기계 학습 작업을 수행할 수 있는 시스템을 제안합니다.

2021 ~ 2022

BoTNet: [11]에서는 BoTNet이라는 새로운 백본 아키텍처를 소개하였습니다. 이 아키텍처는 ResNet의 마지막 세 개의 bottleneck 블록에서 공간 컨볼루션을 글로벌 self-attention으로 대체하여 성능을 향상시킵니다. BoTNet은 COCO Instance Segmentation 벤치마크에서 44.4% Mask AP와 49.7% Box AP를 달성하였으며, ImageNet 벤치마크에서 84.7%의 top-1 정확도를 기록하였습니다.

Routing Transformer: [12]에서는 self-attention의 계산 및 메모리 요구 사항을 줄이기 위해 동적 sparse attention 패턴을 학습하는 방법을 제안하였습니다. 이 모델은 online k-means를 기반으로 한 sparse routing 모듈을 사용하여 self-attention의 복잡성을 줄입니다.

HaloNet: [13]에서는 self-attention 모델이 ResNet-50과 같은 기본 컨볼루션 모델보다 더 나은 성능을 발휘할 수 있음을 보여주었습니다. HaloNet이라는 새로운 self-attention 모델 패밀리를 개발하여 ImageNet 분류 벤치마크에서 state-of-the-art 정확도를 달성하였습니다.

Transformer Scaling: [14]에서는 Transformer 아키텍처의 스케일링 행동에 관한 연구를 통해 모델 크기뿐만 아니라 모델의 형태가 downstream fine-tuning에 중요한 영향을 미친다는 것을 발견하였습니다.

Model Efficiency: [15]에서는 모델 효율성의 중요성을 강조하며, 다양한 비용 지표가 서로 상충될 수 있음을 논의하였습니다. 효율성 메트릭의 보고를 개선하기 위한 제안을 제시하였습니다.

DeepConsensus: [16]에서는 DeepConsensus라는 transformer 기반 접근 방식을 소개하여 PacBio HiFi reads의 오류를 42% 줄였습니다. 이는 유전자 완전성을 증가시키고, 변이 호출 오류를 줄이는 데 기여하였습니다.

REALM++: [17]에서는 REALM의 fine-tuning을 연구하여 QA 작업에서 성능을 향상시킬 수 있는 방법을 탐구하였습니다. REALM++는 더 큰 Open Domain QA 모델과 비슷한 성능을 발휘하면서도 효율성을 입증하였습니다.

2023 ~ 2024

DeepConsensus: [18]에서는 Pacific Biosciences의 HiFi reads의 정확성을 높이기 위해 DeepConsensus라는 새로운 방법을 소개하였습니다. 이 방법은 기존의 pbccs 방법보다 42% 더 적은 오류를 발생시키며, HiFi reads의 수율을 Q20에서 9%, Q30에서 27%, Q40에서 90% 증가시킵니다. 이로 인해 유전자 완전성이 증가하고, 잘못된 유전자 중복률이 감소하며, 조립 기반 정확성이 향상됩니다.

이미지 생성 방법: [19]에서는 이미지 생성에 관한 방법을 설명하고 있습니다. 이 방법은 픽셀-컬러 채널 쌍의 생성 순서에 따라 이미지의 강도 값을 생성하며, 디코더 신경망을 사용하여 각 픽셀-컬러 채널 쌍에 대한 강도 값을 선택합니다. 이 과정에서 로컬 마스크드 셀프 어텐션 서브레이어가 포함됩니다.

입력 시퀀스로부터 출력 시퀀스 생성: [20]에서는 입력 시퀀스로부터 출력 시퀀스를 생성하는 시스템을 설명합니다. 이 시스템은 인코더 신경망을 사용하여 입력 시퀀스를 받아 네트워크 입력의 인코딩된 표현을 생성합니다. 각 인코더 서브네트워크는 입력 위치에 대한 서브네트워크 출력을 생성하며, 인코더 셀프 어텐션 서브레이어를 포함합니다.

Transformer 모델의 응용: [21]에서는 Transformer 모델이 자연어 처리(NLP) 분야에서 뛰어난 성과를 거두었으며, 이러한 성공이 컴퓨터 비전 커뮤니티에도 영향을 미쳐 이미지 인식, 객체 탐지, 세그멘테이션 등 다양한 비전 및 멀티모달 학습 작업에 적용되고 있음을 설명합니다.

신경망의 히든 레이어: [22]에서는 신경망의 히든 레이어에 대해 설명하며, 각 히든 레이어의 출력이 다음 레이어의 입력으로 사용된다는 기본적인 개념을 다루고 있습니다.

출처 정보:

- [1] 2017 : Attention is All You Need: https://user.phil.hhu.de/~cwurm/wp-content/uploads/2020/01/7181-attention-is-all-you-need.pdf

- [2] 2018 : Graph Networks: https://arxiv.org/abs/1806.01261

- [3] 2018 : Relative Position Representations: https://arxiv.org/abs/1803.02155

- [4] 2018 : Image Generation with Transformer: http://proceedings.mlr.press/v80/parmar18a.html

- [5] 2018 : Music Transformer: https://arxiv.org/abs/1809.04281

- [6] 2018 : Mesh-TensorFlow: https://proceedings.neurips.cc/paper/2018/hash/3a37abdeefe1dab1b30f7c5c7e581b93-Abstract.html

- [7] 2019 : Convolutional networks, self-attention, ImageNet, COCO: http://openaccess.thecvf.com/content_ICCV_2019/html/Bello_Attention_Augmented_Convolutional_Networks_ICCV_2019_paper.html

- [8] 2019 : Convolutions, self-attention, ResNet-50, ImageNet, COCO: https://proceedings.neurips.cc/paper/2019/hash/3416a75f4cea9109507cacd8e2f2aefc-Abstract.html

- [9] 2019 : Vision-and-Language Navigation, CLS, Room-for-Room: https://arxiv.org/abs/1905.12255

- [10] 2020 : Self-attention, machine learning, unified representation space: https://patents.google.com/patent/US10789427B2/en

- [11] 2021 : BoTNet : http://openaccess.thecvf.com/content/CVPR2021/html/Srinivas_Bottleneck_Transformers_for_Visual_Recognition_CVPR_2021_paper.html

- [12] 2021 : Routing Transformer : https://direct.mit.edu/tacl/article-abstract/doi/10.1162/tacl_a_00353/97776

- [13] 2021 : HaloNet : http://openaccess.thecvf.com/content/CVPR2021/html/Vaswani_Scaling_Local_Self-Attention_for_Parameter_Efficient_Visual_Backbones_CVPR_2021_paper.html

- [14] 2021 : Transformer Scaling https://arxiv.org/abs/2109.10686

- [15] 2021 : Model Efficiency : https://arxiv.org/abs/2110.12894

- [16] 2021 : DeepConsensus : https://www.biorxiv.org/content/10.1101/2021.08.31.458403.abstract

- [17] 2021 : REALM++ : https://arxiv.org/abs/2104.08710

- [18] 2023 : Circular consensus sequencing: https://www.nature.com/articles/s41587-022-01435-7

- [19] 2024 : Methods, systems, and apparatus for generating an output image: https://www.freepatentsonline.com/y2024/0193926.html

- [20] 2024 : Methods, systems, and apparatus for generating an output sequence: https://patents.google.com/patent/US20240144006A1/en

- [21] 2023 : Transformer models in vision and multi-modal learning: https://ieeexplore.ieee.org/abstract/document/10269654/

- [22] 2023 :Neural networks with hidden layers: https://patents.google.com/patent/EP4156034A1/lista_geral_produtos_quimicos.pdf

1 thought on “[Mostly AI-Generated] “Attention is all you need” 논문의 1저자인 Ashish Vaswani는 그 이후에 어떤 연구를 했을까?”

Comments are closed.